真就是分久必合,合久必分?

最近,韩媒 The Elec 披露了一个相当引人瞩目的消息:三星正在应苹果的要求,试图将内存独立封装于芯片。

具体来说,苹果计划从 2026 年起,在 iPhone 中放弃当前主流的 PoP(Package on Package)封装方式——将 SoC 与 LPDDR 内存重叠封装在一起,转而将 LPDDR 内存独立封装。按照报道的说法,苹果转变的背后:

核心是为了 Apple Intelligence。

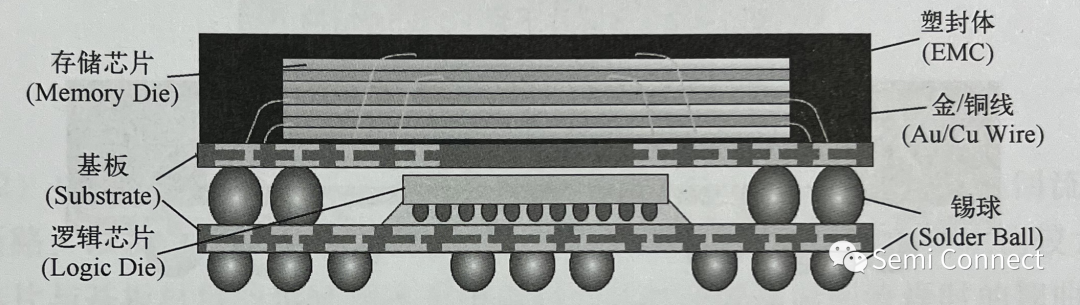

逻辑不难理解,从训练到推理,大模型性能的一大瓶颈就是内存带宽,而当前手机普遍采用的 PoP 封装——将内存直接堆叠在 SoC 上,在带宽上非常受限,还存在积热问题。

PoP 封装示意图,图/ Semi Connect

而独立封装的 LPDDR 内存,将在带宽和散热两方面直接改进内存与芯片之间的数据吞吐效率,进而提高 iPhone 的 AI 性能。但苹果的这个计划也不免让很多人产生更大的疑问,毕竟这和 M1 芯片开始采用的「统一内存架构」似乎截然相反。

简单来说,苹果在 Mac 上刚把内存塞进芯片没几年,而在 iPhone 上却要把芯片和内存拆开。

另一方面,手机的 AI 化也已经在 2024 年成为了行业共识,理论上其他手机厂商也要面临 PoP 封装下内存带宽等问题,又是否会推动高通、联发科等上游厂商作出改变?甚至跟随苹果将内存「独立封装」的步伐?

手机 AI 化加速,内存「不够用」了

从 iPhone 到 Pixel,再到荣耀到 OPPO,手机 AI 化的浪潮在 2024 年可以说是愈演愈烈。在用户的层面,AI 在日常使用中的存在感实际上也有了很大的加强,从全新升级 AI 语音助手,到 AI 修图、AI 总结等实用功能。

几乎无一例外,各大厂商都在 AI 领域押下重注,而在令人眼花缭乱的 AI 化升级背后,对手机核心硬件的要求其实也在快速改变。尤其是以大模型技术为基底,AI 对手机的内存提出了史无前例的需求——不仅是容量,更重要的是带宽。

在大模型的本地推理中,内存需要以极快的速度读取、写入和交换数据。理论上,内存带宽越高,AI 任务的响应速度越快;反之,内存带宽不足则会导致处理瓶颈。

图/苹果

但在目前,智能手机普遍采用 PoP(Package on Package)封装技术,将内存叠在 SoC 上,再通过引脚实现数据传输。这种设计的初衷很简单:智能手机空间有限,PoP 封装能够极大地节省主板面积,同时也能在 SoC 和内存之间提供短距离的高速互连。

换句话说,它曾是解决手机内部空间紧张问题的「终极方案」。但当初的「香饽饽」,现在看却是有些力不从心了在 AI 化浪潮的推动下,PoP 封装暴露出了两大缺陷:带宽和积热。

先说带宽瓶颈。在 PoP 封装中,尽管 GBA 焊点间距越来越小,引脚数量越来越多,SoC 和内存之间的数据传输仍然受限于物理设计,很难有大幅提升。简言之,PoP 的互连密度有限,在面积几乎不可能增大的情况下,很难满足 AI 大规模计算对带宽越来越高要求。

再说积热问题。PoP 封装将内存直接堆叠在 SoC 之上,让热量集中在芯片顶部,导致热量堆积和性能瓶颈。尤其是在高负载的 AI 任务下,这种结构的散热效率明显不足,容易导致芯片过热,影响性能和稳定性。

在这种背景下,「变」实际上是一种必然。无论是提升带宽还是优化散热,PoP 封装显然难以满足 AI 任务的需求。

但另一个关键问题在于,为什么苹果打算在 A 系列芯片将内存「拆开」独立封装,而不是看齐桌面端的苹果 M 系列芯片和英特尔酷睿 Ultra 200S 系列——把内存整合在芯片之中。

内存「独立」,是 AI 手机更靠谱的解法

当 PoP 封装显现出带宽和散热上的瓶颈时,摆在智能手机面前的选择变得有限:要么像 M 系列芯片一样,将内存直接封装进 SoC,实现统一内存架构(UMA);要么反其道而行,将内存与 SoC 分开独立封装。

现在来看,苹果似乎已经做出选择,甚至开始推动上游一起实现内存的独立封装。这个决定看似与统一内存架构背道而驰,但它并非偶然。独立封装和 UMA 各自的设计逻辑截然不同,而这背后,是两种完全不同的硬件需求。

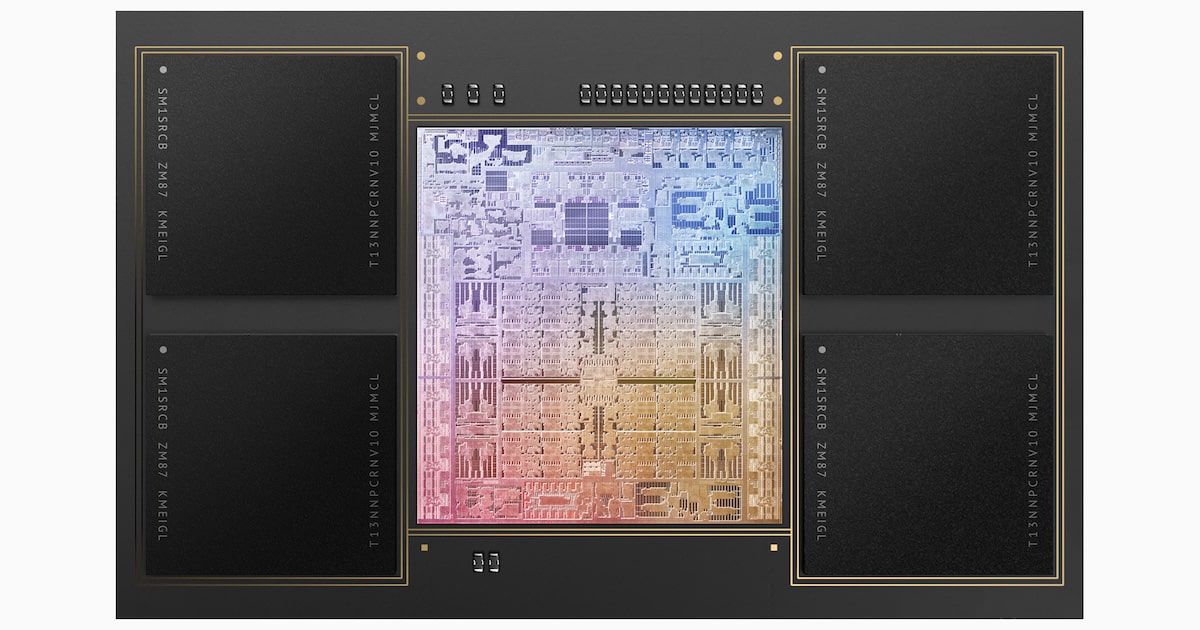

苹果 M1 Max,图/苹果

今天我们都知道,统一内存架构(UMA)这类设计最大的优势在于整合和共享。通过将内存直接封装进 SoC,UMA 可以让 CPU、GPU、NPU 等不同计算单元共用一块内存,避免数据在多个内存模块间频繁复制,从而减少延迟,提升效率。

这种设计在 Mac 和 iPad Pro 这样的生产力设备中被证明非常成功,尤其是在图形处理、大型应用和 AI 训练等高性能任务中,UMA 有着很大的优势。

然而,UMA 这类方案在智能手机上的适用性却受到多方面限制。最典型的就是功耗和散热,将内存集成到 SoC 内后,虽然会带来了更高的带宽和性能,但也增加了整体功耗和热量。

但智能手机电池容量有限,AI 任务如果频繁调用内存,会导致耗电量显著上升,进而影响续航。同时内部空间也极其有限,要在 SoC 里面塞下另一个「发热大户」,很容易影响体验。

iPhone 16 Pro,图/苹果

此外,SoC 的尺寸面积也是问题,UMA 这类封装方案虽然整合度高,但却会导致芯片面积和厚度增加,削弱机身设计的灵活性。再加上相应的封装工艺复杂且昂贵,会显著提高生产成本,并最终体现在产品定价上。

相比之下,内存独立封装的设计可能更符合智能手机的实际需求,不只是独立封装允许采用更新的内存技术(如 LPDDR6),通过宽总线设计实现更高的带宽,还能避免了 PoP 封装互连密度带来的带宽限制。

而对于生成式 AI 来说,带宽的提升直接转化为计算速度的提高。除此之外,散热的优化、设计的灵活性等也都是独立封装内存的优势所在。

当然,独立封装并非完美无瑕。它依然需要解决机身空间占用、信号延迟等问题。但在当前技术条件下,它无疑是一种更加实际、可行的方向。至于这种方向是否会成为 AI 手机的共同解法?可能还要再等等看。

AI手机浪潮爆发,内存技术必须要变了

如果按照规划,苹果应该会在 2026 年推出搭载 A20 芯片的 iPhone 18 系列,将会首发采用全新的「独立封装内存」。理论上,iPhone 18 系列至少在内存带宽上会面临更少的瓶颈。

那安卓阵营呢?与 iPhone 一样,安卓手机在 AI 时代也是要面对内存带宽(不是容量)的瓶颈问题,除非大模型在运行机制上发生大的变化,否则还是要严重依赖芯片与内存之间的大规模数据传输。

图/雷科技

换言之,安卓阵营同样需要「变」。但怎么「变」却是一个有待回答的问题,一种可能是跟随苹果的脚步,改 PoP 封装为独立封装内存,另一种可能继续在堆叠设计上,采用更先进的信号互连技术或者工艺优化,来缓解带宽不足的问题。

但具体如何选择,还是看安卓手机厂商以及高通、联发科等芯片厂商之间的碰撞,能否找到更适合安卓阵营的「解法」。

不过至少我们可以确定,智能手机的 AI 化趋势正在改变很多东西。不只是软件,还有内存的封装方案,甚至从芯片设计,到 ID 设计,或许我们都会在接下来几年看到全新的变化。

25年1月7日,CES(国际消费电子展) 2025 即将盛大开幕,雷科技报道团蓄势待发,即将飞赴美国·拉斯维加斯现场全程报道,敬请关注。

雷科技

雷科技