很长一段时间里,人们对于CPU核显的性能,都还停留在「能用」的阶段, 不过苹果的M系列芯片核显却颠覆这一认知,让大家意识到核显的性能其实也有很大的进步空间。

在核显领域,强大的并不只有苹果,在独显市场被英伟达打得满地找牙的AMD,前段时间就曝光了目前最强的x86架构核显,并将会搭载于未来发布的Radeon 8000S系列上。

图源:推特

作为x86生态的一员,AMD的核显在泛用性上无疑是远远超越苹果的,而且从目前曝光的信息来看,其性能更是一个大“惊喜”。

AMD核显大战独显,底气何在?

近日曝光的AMD新核显,其芯片代号已经基本确定,并非沿用此前的Radeon 800M/900M,而是直接更名为Radeon 8060S和Radeon 8050S。新的命名方式与AMD积极发布的下一代RX独立显卡保持一致,换言之所采用的核心与AMD的独显大概率是同款。

虽然此前AMD也尝试过将独显核心部署到CPU里,但是受限于工艺制程,并没有取得很好的效果,所以后续还是单开一个序列,只是沿用了独显的同款GPU架构。不过,即使并非同款核心,出色架构设计带来的性能提升也让AMD的APU(AMD对拥有高性能核显单元的CPU的称呼)成为x86最强。

而在台积电的3nm制程成熟后,加上DDR5内存的成熟以及CAMM2内存标准的正式确定,AMD也终于找到了进一步提升核显性能的机会。从曝光的信息来看,Radeon 8060S/8050S将分别拥有40/32个CU单元,其中Radeon 8060S的单元数与苹果的M4 Max一致,其实际性能或将接近移动版的RTX 4070。

图源:微博

如果曝光信息无误,那么这将会是核显性能首次能够与高端独立显卡角力,要知道上一代核显的实际性能只是刚好超过GTX 1650的水平(英伟达在2019年发布的入门级独显),而RTX 4070则是英伟达2023年发布的高端显卡,如果按综合测试的基准成绩来算,RTX 4070的性能约等于GTX 1650的3.8倍。

如此大的提升是怎么做到的?很简单,看看CU单元数量就知道了,Radeon 890M的CU单元数量只有16个,而Radeon 8060S则是40个,是前者的2.5倍,即使其他参数不做调整,性能也将是前者的两倍以上。

而且,搭载Radeon 8060S的锐龙AI MAX 300系列将会采用chiplet分离式设计,简单来说将GPU芯片与CPU芯片分开封装并彼此独立。因此可以在CPU里塞进超大规模的GPU核心,甚至从曝光的内部设计图来看,GPU核心的面积要明显大于CPU核心。

另外,chiplet分离式设计还可以让AMD将HBM3内存集成到芯片内,作为GPU核心的独立显存使用,解决主板内存带宽和速度无法满足GPU性能释放的问题。正是因为有望解决了GPU核心以及显存带宽问题,才让新一代核显在性能上出现了惊人的突破。

核显性能媲美高端独显,或许真的不只是说说而已了。

AI时代,核显成芯片巨头必争之地

为什么AMD要执着于将高性能的GPU塞进CPU里?以前主要是为了押注入门娱乐PC的赛道,只需要购买一个比同规格CPU贵一点的APU,你就可以得到一个高性能CPU+入门级独显性能的核显,能够满足网游及部分单机游戏的娱乐需求,而且因为不需要考虑显卡的安装,可以做成盒子大小的迷你主机,便于部署和摆放。

但是随着AI大模型的出现,APU的用途就悄然发生了变化,核显的用途不再是视频编解码加速和游戏,而是成为AI算力的一部分。虽然现在的CPU大多将NPU作为主要的AI算力来源,但是GPU在并行计算和高计算量任务方面的优势是无可替代的。

举个例子,AI大模型中非常热门的文生图功能,在部分AI PC上已经实现了端侧运行,但是实际效果并不好,往往只能生成构图简单且小尺寸的图像。这是因为NPU虽然在AI运算上非常高效,但是却不具备GPU的超强并行计算性能,难以进行复杂的非线性操作和深层次的模型计算。

实际上,NPU和GPU在文生图等功能上是可以互补的,利用NPU的高效推理分析和理解用户需求,同时生成简单的图像框架,再用GPU来执行更深层次的优化并丰富画面,最大程度地利用各计算模块的优势,就可以提供更高效的AI服务。

未来的AI功能想要在图像分析、生成、修改等方面进行更深层次的功能探索,那么GPU就是必需的,因为其本身的性能特点是无可替代的。而且,不要觉得这些功能离你还很遥远,就以我们常用的Adobe Photoshop来说,新版本已经支持大量AI功能,并且提供本地端侧的AI功能支持。

图源:Adobe

而在实际测试中,虽然没有独立显卡的PC也可以运行端侧AI功能,但是却有大量功能被限制,即使是可用的功能效率也大打折扣。所以,Adobe建议用户搭配至少拥有4GB显存的GPU,以此来保证端侧AI功能的基础功能都可以启用。

随着Adobe在旗下软件中普及AI功能,轻薄本的核显性能已经无法满足需求,除非你只打算使用Adobe套件的基础功能,否则一个性能过得去的GPU就是必需的,不管它是独显还是核显。

Adobe只是整个AI生态的其中一部分,未来的AI PC显然不会止步于此。

AI PC爆发,APU核显将成为主流方案?

那么问题来了,为什么一定要核显?CPU+独显的组合难道不行吗?并非如此,APU和CPU+独显都是未来AI PC的方向,但是侧重点却有所不同。CPU+独立显卡,也就是现在的高性能笔记本电脑,虽然性能强大但是因为需要应付两个热源,所以对散热系统要求更高,无法做到真正的轻薄设计。

但是APU不同,因为CPU、GPU等都被封装到一个芯片里,可以通过均热板等技术更好地优化散热系统,在保持散热系统轻量化的同时满足散热需求,更好地满足移动办公需求。

换言之,APU能够满足AI PC的移动化和随时部署要求,虽然在性能峰值等方面肯定无法与CPU+独显的组合相比,但是却可以更好地部署在小型PC、移动PC里。当然,一个高性能的APU本身功耗肯定不会低,届时就只能看CPU厂商如何进行取舍了。

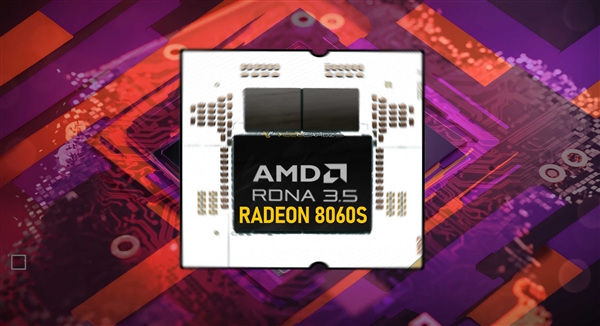

此外,APU可以利用统一内存等技术,让CPU、GPU共用高速内存,虽然成本会显著上升,但是也可以提供更高的性能,并且满足大型AI模型的运行要求。比如苹果的Mac就利用超大统一内存的优势,能够流畅运行RTX 4090都无法流畅运行的AI模型,不管是AI开发还是AI应用,都有着更显著的优势。

图源:极客湾

实际上,CPU+GPU的组合芯片已经被多个半导体巨头盯上,除了前面提到的苹果和AMD外,英特尔、英伟达也在探索这个市场,英特尔的Xe-LPG就采用了独显同等核心,只是性能与AMD还有很大差距,仅相当于780M的水平。至于英伟达,则是更激进一些,选择直接将CPU内置到GPU里,反其道而行之。

其实英伟达的思路也是可以理解的,既然自家的优势在于GPU而非CPU,那么将GPU打包为主要卖点,CPU作为附赠功能来销售就可以更好地发挥出英伟达的技术优势,只是对于PC市场来说这样的组合确实很新鲜。

核显赛道以前是英特尔独秀,后来AMD加入战场,现在则是进入三国争霸的阶段,英特尔、AMD、英伟达都想在这个市场上取得优势,因为这将关系到未来的AI PC市场走向。苹果呢?作为四大主流芯片平台里唯一的封闭式生态,苹果虽然并不直接参与竞争,但是却已经成为其余三家无法忽视的对手。

未来,随着苹果逐渐完善自己的系统生态,Mac设备的市场份额会不可阻挡的上升,虽然因为价格等问题并不会直接威胁到x86 PC的核心地位,但是却会蚕食掉相当一部分移动PC和AI PC市场。

谁能想到,曾经毫不起眼,被视为CPU附赠品的核显,会有一天成为兵家必争之地。

雷科技

雷科技